ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

大規模言語モデル(LLM)が示す高度な能力は、単に膨大な知識を記憶し、関連する情報を検索しているだけなのか、それとも未知の問題に対して人間のような推論を行っているのか。このAI研究における根源的な問いに対し、一つの明確な答えを提示する論文が「AINSTEIN」です。

この記事は、きっとあなたの役に立ちます。

- LLMの能力の本質(記憶か推論か)に関心がある方

- AIによる科学的発見や研究開発の未来像を知りたい方

- 最新のAI評価手法や研究動向を正確に理解したい方

それでは、LLMの科学的問題解決能力を厳密に測定した本研究の核心に迫りましょう。

【本記事のベース論文】

タイトル: AINSTEIN: ASSESSING THE FEASIBILITY OF AI-GENERATED APPROACHES TO RESEARCH PROBLEMS

著者: Shambhavi Mishra, Gaurav Sahu, Marco Pedersoli, Laurent Charlin, Jose Dolz, Christopher Pal, et al.

雑誌名あるいは会議名: arXiv (ICLR 2025 submission)

出版年: 2025

目次

AINSTEINフレームワーク:LLMの「真の推論能力」を測るための実験設計

問い:LLMは事前知識だけで未知の問題を解けるか?

研究チームは、LLMの能力を測るために、以下の非常に限定的な条件下での問いを設定しました。

Q: LLMは、事前学習で得たパラメトリック知識(内部に保持する知識)のみを用いて、AI分野の未知の研究課題を解決できるか?

この問いの核心は、「追加学習や外部情報へのアクセスを一切禁じる」という点にあります。ドメイン特化のファインチューニングや、外部データベースを参照するRetrieval-Augmented Generation (RAG) といった支援技術を排除することで、LLMが持つ純粋な問題解決能力を単離して評価することを目指しました。

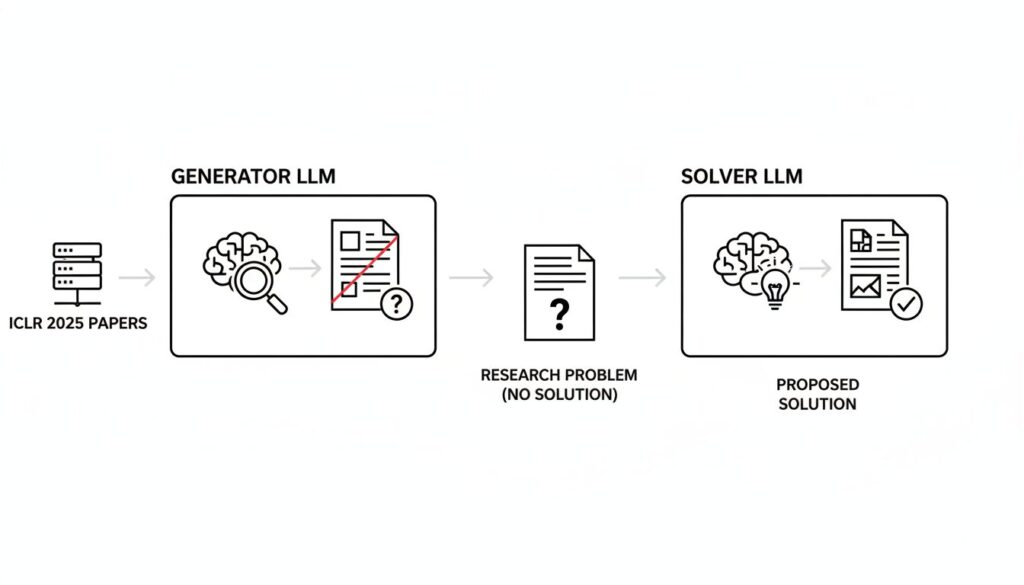

科学的探究プロセスを模倣した2段階のパイプライン

この問いを検証するために構築されたのが、「AINSTEIN」フレームワークです。このフレームワークは、問題の定式化と解決策の生成を意図的に分離しています。

- フェーズ1:問題抽出 (Problem Extraction) 「ジェネライザー」と呼ばれるLLMエージェントが、ICLR 2025の論文要旨(計1,214本)を読み込みます。ここでのタスクは、論文に書かれている解決策への言及やヒントを完全に除去し、「研究課題」そのものだけを客観的に抽出することです。これにより、次のフェーズで答えに関する情報が漏洩することを防ぎます。

- フェーズ2:解決策生成 (Solution Generation) 抽出された「研究課題」の情報だけが、元の論文を知らない別のLLMエージェント「ソルバー」に渡されます。ソルバーは、与えられた課題に対し、技術的に妥当な解決策をゼロから考案します。

この設計により、「記憶された答えの参照」ではなく、「未知の問題に対する能動的な解決策の生成」という能力を評価することが可能になります。

【ロジの視点】

この研究の卓越性は、その厳格な実験設計にあります。LLMの評価では、「訓練データに含まれていた問題を記憶していただけではないか」という汚染(contamination)の問題が常に付きまといます。AINSTEINは、問題の抽象化と解決策の分離、そして知識カットオフの徹底により、この問題を回避し、LLMの「純粋な推論能力」を測定する信頼性の高い土台を構築しています。

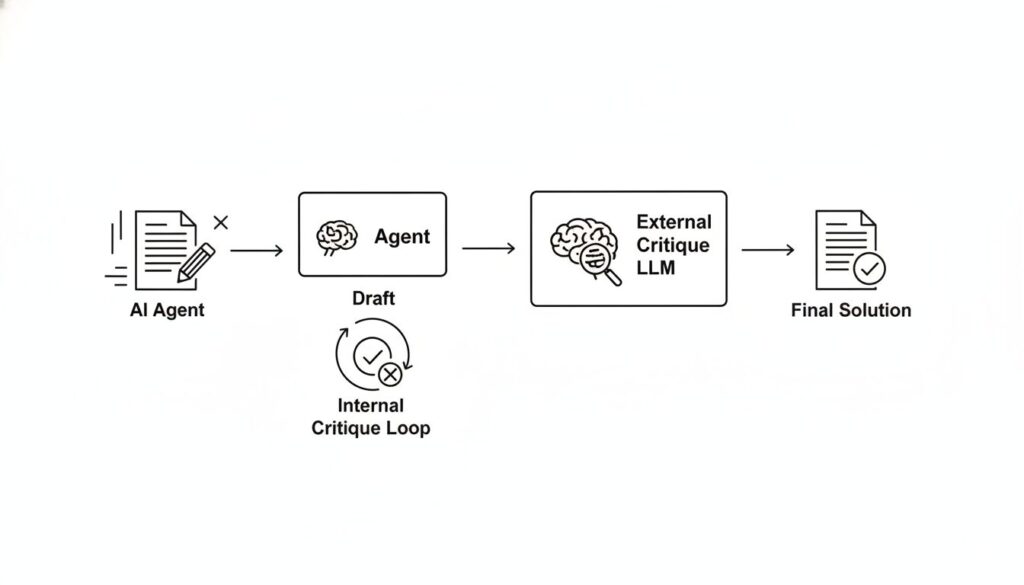

科学的査読を模した「反復的批評ループ」

AINSTEINのもう一つの重要な特徴は、科学論文が査読プロセスを経て品質を高めていく過程を模した、二重の「批評ループ」を導入している点です。

- 内部批評ループ (Internal Critique Loop): エージェント(ジェネライザーまたはソルバー)は、生成した草案(問題定義文や解決策)を、まず自分自身で評価基準に照らして批評します。もし基準を満たさなければ、自己のフィードバックに基づき修正を行います。この高速な自己修正プロセスを最大20回繰り返します。

- 外部批評ループ (External Critique Loop): 内部ループを通過した草案は、次により高性能な外部のLLMモデルによる、より厳格な評価を受けます。ここで不合格となった場合、外部からのフィードバックも加えて、再度内部ループからプロセスをやり直します。

この「高速な自己修正」と「厳格な外部評価」の組み合わせにより、生成物の品質を保証しています。

実験結果が示すLLMの能力と特性

厳密なフレームワークの下で行われた実験から、LLMの科学的問題解決能力に関する3つの重要な知見が得られました。

1. 解決策の品質は「自己修正能力」に強く依存する

最も決定的な要因は、内部批評ループで用いられるモデル () の性能でした。Table 3が示すように、内部エージェントとしてGPT-OSS-120Bを用いた構成は、成功率74.05%を達成し、次点のQwen-235B(43.82%)を大幅に上回りました。この結果は、質の高い解決策を生み出すには、強力な外部評価者よりも、効果的な自己修正を迅速に繰り返す能力がより重要であることを示唆しています。

2. 「完全な再発見」は稀だが、「有効な新規の代替案」を創出する

本研究で最も重要な発見は、「再発見」と「新規性」の評価結果に見られます。

- 再発見 (Rediscovery): LLMが生成した解決策が、人間による元の論文の解決策と完全に一致した割合は、厳格な評価基準 (

) では15〜20%と非常に低い値でした。これは、LLMが人間の思考プロセスを正確に再現するケースは稀であることを意味します。

- 新規かつ有効 (Novel & Valid): その一方で、元の論文とは異なるアプローチでありながら、科学的に有効で課題を解決できる解決策を生成した割合は、評価基準の厳格さに関わらず安定して高いままでした。

この対照的な結果は、LLMが単に記憶から正解を検索しているのではなく、与えられた問題に対して、既存の知識を組み合わせて有効な代替案を能動的に「創造」していることを実証しています。

KEY SIGNAL:

LLMは、人間が考案した解決策を完全に再現する(再発見する)能力は限定的である一方、科学的に有効な「新規の代替策」を生成する顕著な能力を持つ。この問題解決能力の成否は、特に自己修正を担う内部モデルの性能に大きく左右される。

3. 論文の採択レベル(難易度)による性能差は小さい

実験対象の論文を採択レベル(Oral, Spotlight, Poster)で層別化して分析したところ、LLMの成功率は、論文の新規性やインパクト(一般的にOralが最も高いとされる)に大きくは影響されないことが明らかになりました。トップ性能のGPT-OSS-120Bは、どのレベルの論文から抽出された問題に対しても、安定した成功率を示しました。これは、LLMの能力が特定の専門知識の深さだけでなく、より汎用的な問題解決能力に根ざしている可能性を示唆しています。

まとめ:AINSTEINが示すAIの科学における役割

この記事のポイントを再確認しましょう。

- AINSTEINは、追加学習や外部情報なしで、LLMが未知の科学的問題を解決する能力を厳密に評価するフレームワークである。

- 解決策の品質は、外部からの評価よりも、高速な自己修正ループを回す内部モデルの性能に強く依存する。

- LLMは、人間による解決策を完全に再現することは稀だが、科学的に有効な新規の代替案を創造する高い能力を持つ。

- LLMの問題解決能力は、問題の難易度やインパクトによらず、安定して発揮される傾向がある。

AINSTEINの研究は、現代のLLMが単なる情報検索システムを超え、洗練されたパターンマッチングに留まらない、潜在的な科学的推論能力を有していることを説得力のある形で示しました。論文の著者らも指摘するように、本研究はAI分野に限定されており、今後の課題として、物理学や生物学など他の科学分野への応用が期待されます。AIが研究者の思考を補助し、新たな発見を加速させる未来に向けた、重要な一歩と言えるでしょう。

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。