ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

あなたはGPT-4oに専門的な質問を投げかけたとき、返ってきた回答の「出典」をどこまで疑っていますか。もし、マイナーな専門分野について尋ねているなら、警戒レベルを最大まで引き上げるべきです。最新の研究データは、AIが情報の空白を埋めるために、息をするように文献をでっち上げる実態を暴き出しました。

この記事は、情報の正確性を重視するあなたにとって不可欠なガイドとなります。

タイトル: Influence of Topic Familiarity and Prompt Specificity on Citation Fabrication in Mental Health Research Using Large Language Models: Experimental Study

著者: Jake Linardon, Hannah K Jarman, Zoe McClure, Cleo Anderson, Claudia Liu, Mariel Messer

雑誌名あるいは会議名: JMIR Mental Health

出版年: 2025年

- 業務や研究でChatGPTをリサーチに活用し、その出力精度に漠然とした不安を抱いている方

- AIの「ハルシネーション(幻覚)」が発生する具体的な条件とメカニズムを、数値ベースで理解したい方

- 生成AIのアウトプットを検証する際、直感ではなく論理的なリスク評価基準を確立したい方

オーストラリアの研究チームが発表した論文(Linardon et al., 2025)は、私たちがAIに対して抱くべき信頼の境界線を、冷徹なデータで示しています。今回はこの研究を解剖し、AIとの知的な付き合い方を再定義しましょう。

目次

研究の背景:生産性の追求と信頼性の欠如

アカデミアに蔓延するプレッシャーとAIへの依存

現代の研究者は、常に成果を求められる過酷な競争の中にいます。資金獲得や昇進のためには、質の高い論文を継続的に発表しなければなりません。この「出版か、死か(Publish or Perish)」という強迫的な環境が、多くの研究者をAIツールへと駆り立てています。実際、ある調査ではメンタルヘルス研究者の約7割が、執筆やコーディングの補助としてChatGPTを利用していると回答しました。

しかし、効率化の裏にはリスクが潜みます。それが「ハルシネーション」、すなわち事実に基づかない情報の生成です。

科学の根幹を揺るがす「書誌情報の捏造」

特に深刻なのが、実在しない論文をAIが生成してしまう「引用捏造」です。研究論文において、引用は議論の正当性を担保する証拠そのものです。もし証拠が捏造されたものであれば、その上に構築された論理はすべて無効となります。

これまでもAIによる誤情報は報告されてきましたが、今回の研究が画期的なのは、その発生条件を体系的に検証した点にあります。「トピックの知名度」と「質問の具体性」という2つの変数が、どのようにAIの嘘を誘発するのか。この相関関係を明らかにしたのです。

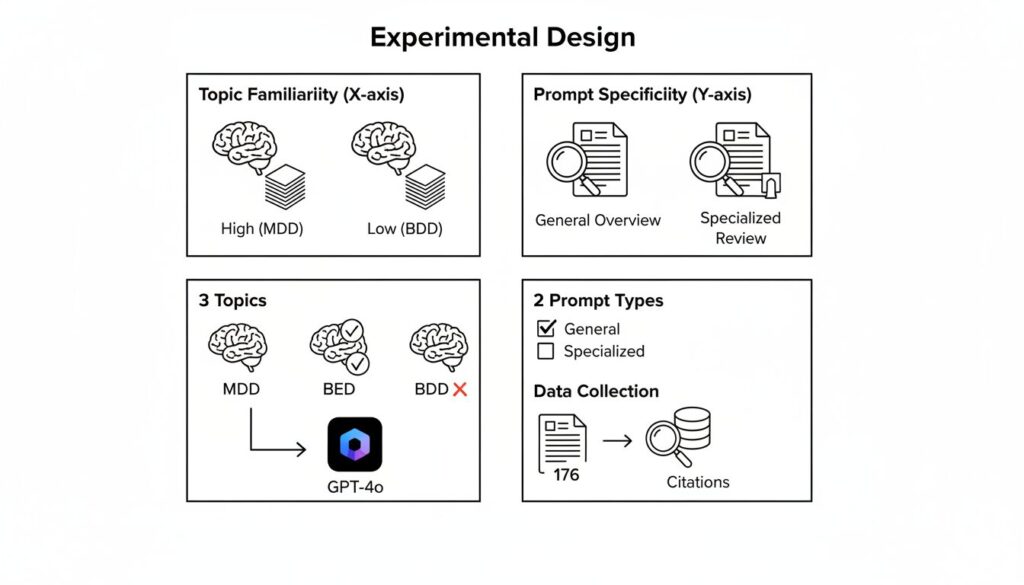

実験設計:AIの限界をあぶり出す比較検証

ディーキン大学の研究チームは、GPT-4oの信頼性を検証するために、認知度と研究量の異なる3つの精神疾患を選定しました。

- 大うつ病性障害(Major Depressive Disorder)

- 研究の蓄積が膨大で、社会的認知度も極めて高い「メジャーな領域」。

- 過食症(Binge Eating Disorder)

- 一定の研究はあるものの、うつ病と比較すれば情報量が劣る「中規模な領域」。

- 身体醜形障害(Body Dysmorphic Disorder)

- 研究数が少なく、一般社会での認知も限定的な「ニッチな領域」。

彼らはこれら3つの疾患に対し、「一般的な概要(症状や治療法)」と「専門的なレビュー(デジタル介入のエビデンス)」という2つのレベルで文献レビューの作成を指示しました。生成された合計176件の引用文献について、Google ScholarやScopusなどのデータベースを駆使し、実在するかどうかを徹底的に追跡調査したのです。

この設計の意図は明白です。学習データの多寡が、AIの出力精度にどう直結するかを数値化することにあります。

分析結果:データの空白地帯でAIは「創作」する

検証の結果、AIの信頼性は扱うトピックによって劇的に変動することが判明しました。

全体の2割が完全な捏造、半数がエラーを含む

まず全体像を見てみましょう。GPT-4oが生成した176件の引用のうち、19.9%は実在しない架空の文献でした。さらに、実在する文献であっても、その約45%には巻号やページ数、DOI(デジタルオブジェクト識別子)などに誤りが含まれていました。結果として、完全に正確で使用可能な文献は全体の54.6%にとどまったのです。

「知名度」と「捏造率」の明確な相関

トピックごとの差は歴然としています。

- 大うつ病(メジャー): 捏造率はわずか 6%。

- 過食症(中程度): 捏造率は 28% に跳ね上がる。

- 身体醜形障害(ニッチ): こちらも 29% と高い水準。

情報が豊富なメジャーな領域では高い精度を維持できるものの、少しでもマイナーな領域に踏み込むと、信頼性は崩壊します。

「専門的な問い」がリスクを増幅させる

特筆すべきは「過食症」におけるデータです。一般的な概要を求めた際の捏造率は17%でしたが、より専門的な「デジタル介入」について尋ねると、捏造率は46%へと急上昇しました。

中程度の知名度を持つトピックであっても、さらに条件を絞り込んで学習データが手薄な領域へ誘導すると、AIは不足した情報を補完するために高確率で虚偽の情報を生成します。

【ロジの視点】

この現象は、大規模言語モデル(LLM)が「事実の検索エンジン」ではなく、「確率的なテキスト生成装置」であることを如実に示しています。学習データが密な領域では、正しい書誌情報が高い確率で結びつきます。しかしデータが疎(スパース)な領域では、AIは統計的に「ありそうな」単語の並び――例えば、その分野で有名な著者の名前と、もっともらしいタイトルの組み合わせ――を合成してしまいます。AIに悪意はありません。システムとして、情報の欠落を統計的な推論で埋め合わせようとした結果、人間から見れば「捏造」となる出力が生まれるのです。

詳細分析:DOIという欺瞞

さらに厄介なのが、デジタルオブジェクト識別子(DOI)の取り扱いです。今回の調査では、捏造された文献にもっともらしいDOIが付与されているケースが確認されました。

しかしそのDOIを追跡すると、64%は全く無関係な別の論文にリンクし、36%は無効なリンクでした。

形式上は完璧に見える引用であっても、その中身は空虚、あるいは誤りです。一見して「論文らしい」体裁が整っているからこそ、検証を怠った際のダメージは計り知れません。

私たちが取るべき戦略:批判的受容のプロセス

この研究データは、AIを業務や研究に組み込む際の明確な指針を与えてくれます。

1. トピックの「情報密度」を推測する

AIに質問する前に、そのトピックが世の中でどれくらい扱われているかを自問してください。インターネット上に大量のテキストが存在するメジャーな話題なのか、それとも専門書や一部の論文でしか語られないニッチな話題なのか。後者であれば、出力された固有名詞や出典は「基本的に誤りである」という前提で向き合う必要があります。

2. 一次情報の確認をプロセスに組み込む

AIが出力した出典情報は、あくまで「探索の手がかり」に過ぎません。提示されたDOIやURLには必ずアクセスし、タイトル、著者、発行年が一致するかを目視で確認する工程を業務フローに固定してください。確認できない情報は、存在しないものとして扱うべきです。

3. 「専門的な絞り込み」への警戒

「〇〇分野の××という特定の技術について論文を挙げて」といった、条件を重ねたニッチな質問は、最もAIの捏造を誘発しやすいパターンです。こうした調査を行う場合は、AIにゼロからリストアップさせるのではなく、既存の文献リストを渡して要約させるなど、入力情報を人間側でコントロールするアプローチが有効です。

KEY SIGNAL:

AIの信頼性は学習データの量に依存するため、ニッチな領域や複雑な条件下では情報の空白を埋めるための「確率的な捏造」が急増する。出力された出典情報の裏取りを徹底することだけが、知的成果物の品質を担保する唯一の手段である。

まとめ

今回の分析から得られる要点は以下の通りです。

- GPT-4oは文献レビューにおいて約20%の確率で引用を捏造し、実在する文献でも約半数に書誌情報の誤りを含んでいた。

- トピックの知名度が低いほど捏造リスクは高まり、メジャーな「うつ病」と比較して、マイナーな「身体醜形障害」では捏造率が約5倍に達した。

- 特定の条件下(中程度の知名度×専門的な質問)では、情報の欠落を補うための捏造が加速し、約半数が架空の文献となるケースも確認された。

- AIの出力は事実の提示ではなく、統計的な推論の結果であることを理解し、人間による厳格なファクトチェックなしでの利用は避けるべきである。

AIは強力なツールですが、全知全能の賢者ではありません。その限界を正しく理解し、人間が論理的にコントロールすることで初めて、真価を発揮します。

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。