ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

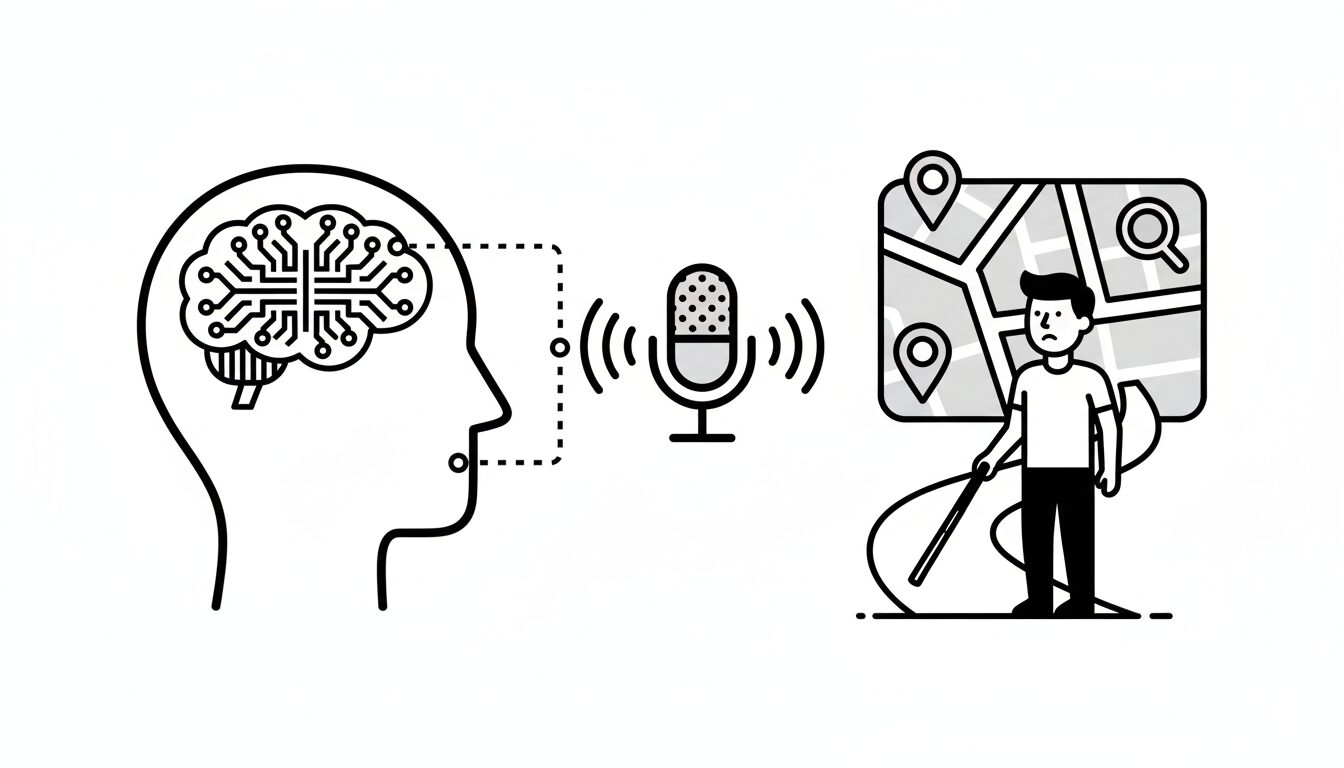

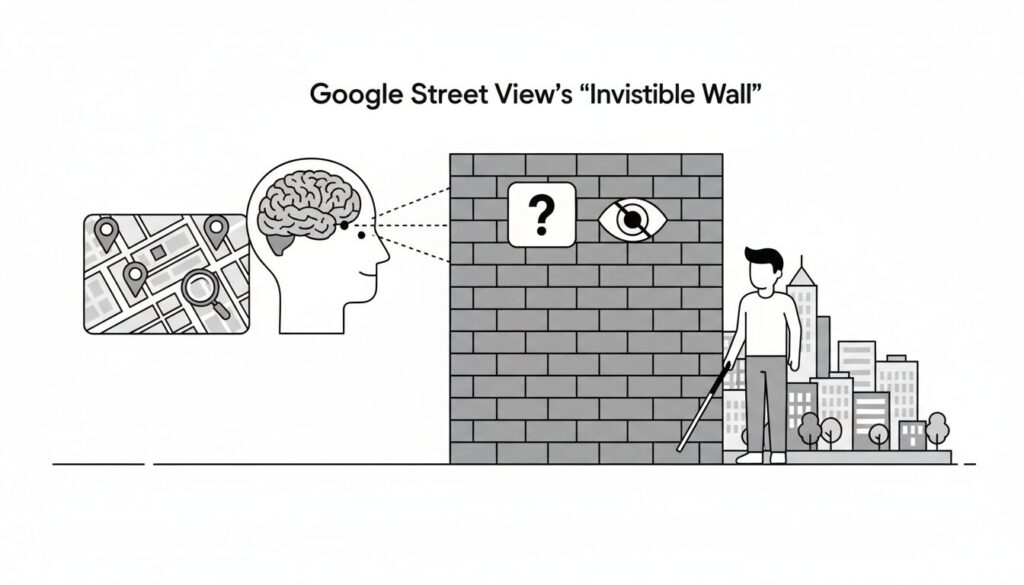

指先一つで世界を探訪できるGoogleストリートビュー。その恩恵は計り知れません。しかし、その体験が「視覚」を前提としているという事実は、これまで見過ごされがちでした。膨大な画像データは、視覚障害を持つ人々にとってはアクセス不能な「見えない壁」だったのです。技術の進歩が、必ずしも全ての人に平等な恩恵をもたらすわけではない。この根源的な課題に対し、AIが画期的な解を提示しました。それが「StreetViewAI」です。

この記事は、きっとあなたの役に立ちます。

- AIがアクセシビリティをどう変えるのか、具体的な事例を知りたい方

- 最新のAI技術、特にマルチモーダルAIの応用例に興味がある方

- テクノロジーがインクルーシブな社会をどう実現するのか、その未来に関心のある方

AIが描き出す「誰も取り残されない地図」の未来を、共に見ていきましょう。

目次

Googleストリートビューの「見えない壁」

誰もが使えるはずの地図が、使えない現実

デジタル地図は、私たちの移動を劇的に変えました。ルート検索、ナビゲーション、そしてバーチャル旅行まで、その恩恵は計り知れません。しかし、その進化の裏側で、視覚に頼るインターフェースは、視覚障害者にとって高いハードルとなっていました。

音声読み上げや触覚ディスプレイなど、これまでに地図のアクセシビリティを高める研究は多く行われてきました。しかし、GoogleストリートビューやAppleのLook Aroundのような、没入感のある360°画像を使った「ストリートスケープ・マッピングツール」は、手つかずの領域でした。

これらのツールは、

- 事前にルートを下見する

- 目的地の入口や周囲の状況を確認する

- 近所の雰囲気を知る

- グランドキャニオンやエッフェル塔など、世界の名所をリモートで訪れる

といった、これまでにない体験を可能にしましたが、そのすべてが「視覚」を前提としていたのです。2,200億枚以上の画像で世界100カ国以上をカバーするGoogleストリートビューも、視覚障害者にとっては宝の持ち腐れでした。

これまでのアクセシビリティ技術の限界

従来の画像認識AIは、画像に何が写っているかを説明することはできても、それが地図上のどこにあって、ユーザーとどのような位置関係にあるのか、といった文脈(コンテクスト)を理解することは困難でした。

「目の前にカフェがあります」と分かっても、「そのカフェの入口はどこ?」「入口までの歩道に障害物はない?」「車椅子でも入れる?」といった、移動に必要な具体的な情報までは得られなかったのです。

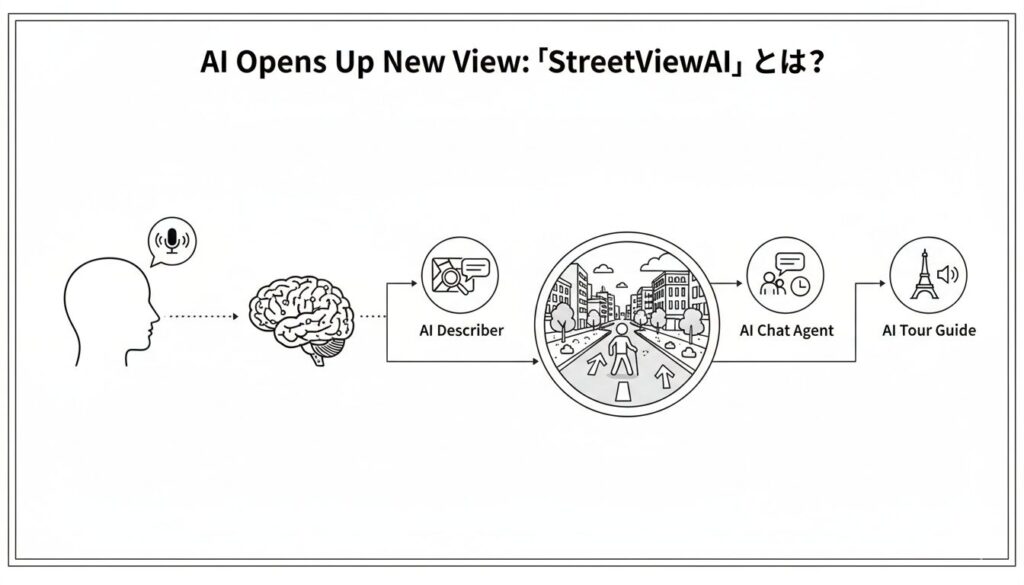

AIが拓く新たな視界「StreetViewAI」とは?

この「見えない壁」を打ち破るために開発されたのが「StreetViewAI」です。StreetViewAIは、最新のマルチモーダルAI(画像やテキストなど複数の情報を同時に理解できるAI)を活用し、視覚障害者がストリートビューの世界を自由に探検できるように設計されています。

「見る」のではなく「対話」するストリートビュー

StreetViewAIの最大の特徴は、AIとの対話を通じて情報を得られることです。ユーザーはキーボードや音声を使って、まるで人間と話すかのように、目の前の風景について質問できます。

- ユーザー: 「このカフェの入口はどこにありますか?」

- StreetViewAI: 「カフェの入口は、あなたの真正面にあります。通りを渡る必要はありません。」

- ユーザー: 「歩道にテーブルや椅子は出ていますか?」

- StreetViewAI: 「はい、歩道にはいくつかのテーブルと椅子が置かれています。入口に向かうには、それらを避けて進む必要があります。」

このように、単なる画像説明ではなく、ユーザーの位置や向き、過去の会話の履歴までをも考慮した、文脈に沿った回答を返してくれます。

StreetViewAIを支える3つのAIエージェント

StreetViewAIには、目的の異なる3つのAIエージェントが搭載されており、状況に応じて最適な情報を提供します。

- AI Describer(説明者): ユーザーが見ている風景の要点を、2~3文で簡潔に説明します。「目の前にはレンガ造りの建物があり、左手には公園の入口が見えます」といったように、現在地の把握を助けます。

- AI Chat Agent(対話エージェント): StreetViewAIの核となる機能です。ユーザーからの自由な質問に答え、過去の移動履歴や会話内容も記憶しているため、「さっき通り過ぎたバス停はどこでしたっけ?」といった質問にも対応可能です。さらに、「左に曲がって」「前に進んで」といった音声コマンドで、バーチャル空間を移動することもできます。

- AI Tour Guide(ツアーガイド): 観光名所などで、その場所の歴史や文化的背景などを、まるでプロのガイドのように生き生きと語ってくれます。「ここはアテネのアクロポリスです。紀元前5世紀に建設され…」といった具合に、バーチャル旅行をより豊かな体験にしてくれます。

【ロジの視点】

単なる画像認識から、位置情報や対話履歴といった「文脈」を理解するAIへの進化。ここにStreetViewAIの本質があります。3つのAIエージェントが協調することで、人間のような柔軟な対話が生まれる。これは、AIが単なるツールから真の「パートナー」へと変貌する過程を示唆しています。

バーチャルな街歩きは、まるでゲームのよう

StreetViewAIの操作は、キーボードの矢印キーで行います。

- ← → キー: 45度ずつ左右に回転

- ↑ ↓ キー: 現在の方向へ前後に移動(約10~15メートル)

- Alt + Jキー: 次の交差点までジャンプ

ユーザーが移動したり向きを変えたりするたびに、StreetViewAIは「現在、北東を向いています」「スターバックスコーヒーが左手12メートル先にあります」といったように、状況を音声で伝えてくれます。これにより、ユーザーは視覚情報なしに、自分がどこにいて、どちらを向いているのかを常に把握できるのです。

11人の視覚障害者が体験して見えた可能性と課題

StreetViewAIの真価を確かめるため、開発チームは11人の視覚障害を持つユーザー(全員がスクリーンリーダー使用者)を対象としたユーザー調査を実施しました。

「まるでその場にいるみたい!」驚きと感動の声

調査結果は、驚くほどポジティブなものでした。参加者たちは、StreetViewAIの総合的な有用性を7点満点中平均6.4点と高く評価し、全員が「もし製品として利用できるなら使いたい」と回答しました。

「ほとんどのナビゲーションシステムは、目的地まであと数メートルのところまでしか案内してくれません。でも、これはドアまで案内してくれるし、そのドアがどんな様子かすら説明してくれるんです。」(参加者 P10)

「もし初めての場所に行くなら、家で事前に慣れておくことができますね。」(参加者 P1)

参加者たちは、これまで不可能だった「事前の下見」が可能になることに、大きな価値を見出していました。

ユーザーが本当に知りたい情報とは?

調査では、参加者がAIチャットエージェントに合計816件もの質問をしました。その内容を分析したところ、ユーザーが街の風景について何を知りたいのか、その具体的なニーズが浮かび上がってきました。

- 空間の向きや位置関係 (27.0%): 「バス停はここからどのくらい離れていますか?」

- モノの存在確認 (26.5%): 「この公園にメリーゴーランドはありますか?」

- 風景の説明要求 (18.4%): 「目の前には何が見えますか?」

- モノや場所の探索 (14.9%): 「一番近い交差点はどこですか?」

- 安全性やアクセシビリティ (5.6%): 「この信号機に音響装置はついていますか?」

これらの質問は、視覚障害者が安全かつ快適に移動するために、いかに詳細で具体的な情報を必要としているかを物語っています。

KEY SIGNAL:

StreetViewAIは、AIとの「対話」によって、これまで視覚に依存してきたデジタル地図を誰もがアクセス可能な情報へと変換する。これは、テクノロジーが物理的な世界の制約を乗り越え、真にインクルーシブな社会を構築する未来への重要な一歩である。

AIの「うそ」とどう付き合うか?見えてきた課題

AIは非常に優秀でしたが、完璧ではありませんでした。全質問のうち、3.9%は誤った回答をし、6.6%は回答を拒否しました。

興味深いのは、参加者の多くがAIの回答を信頼していた点です。これは、StreetViewAIがGoogleマップの正確な地理情報と、AIによる(時に不正確な)画像分析を組み合わせて提供しているため、ユーザーが両者の違いを区別しにくかったことが一因と考えられます。

【ロジの視点】

AIの「ハルシネーション(幻覚)」は、こうした応用技術において常に課題となります。重要なのは、AIの回答を鵜呑みにするのではなく、その不確実性を理解した上で活用するリテラシーです。開発者側がそのリスクをどうユーザーに伝え、制御するかが、今後の信頼性を大きく左右するでしょう。

StreetViewAIが描く、誰も取り残されない未来の地図

StreetViewAIは、単にストリートビューをアクセシブルにしただけではありません。それは、私たちが地図と対話する方法、そして世界を体験する方法そのものを変える可能性を秘めています。

事前リハーサルで、初めての場所も安心して歩ける

「最寄りのバス停からカフェまでの道のりを事前に歩いてみたい」。StreetViewAIを使えば、そんな「バーチャルO&M(歩行訓練)」が可能になります。ルート上の障害物、横断歩道の有無、店の入口の様子などを自宅で安全に確認できることは、視覚障害者の移動における心理的な障壁を大きく下げるはずです。

バーチャル旅行も、世界遺産巡りも

StreetViewAIのAIツアーガイド機能を使えば、世界中の名所を訪れ、その歴史や文化に触れることができます。身体的な制約や経済的な理由で旅行が難しい人々にとっても、世界への扉を開くツールとなり得ます。

すべての人のための「対話型地図」へ

この技術は、視覚障害者だけのものではありません。運転中に「次の角の建物の色は何色?」と音声アシスタントに尋ねると、AIがリアルタイムで画像を分析して答えてくれる。そんな未来も想像できます。

StreetViewAIは、AIがいかにしてアクセシビリティの壁を乗り越え、すべての人々にとってよりインクルーシブな社会を築くことができるかを示す、力強い一例です。

まとめ:AIとの対話が、世界の「見えない壁」を取り払う

この記事では、AIが視覚障害者のためのストリートビュー体験をいかに革命的に変えるか、その核心に迫りました。

この記事のポイントをおさらいしましょう。

- StreetViewAIは、AIとの対話を通じて、視覚障害者がGoogleストリートビューを探検できる世界初のツールである。

- 3つのAIエージェント(説明者、対話者、ツアーガイド)が、文脈を理解した詳細な情報提供とバーチャルな移動を可能にする。

- ユーザー調査では極めて高い評価を得ており、「事前の下見」による移動の安全性向上に大きな期待が寄せられている。

- AIの不正確さ(ハルシネーション)という課題も存在し、ユーザーがAIの限界を理解した上で活用するための仕組みが今後の鍵となる。

StreetViewAIが示す未来は、テクノロジーがすべての人に開かれた世界を実現するための、希望に満ちたシグナルです。

出典情報

この記事は、以下の論文を基に作成されました。

- 論文タイトル: StreetViewAI: Making Street View Accessible Using Context-Aware Multimodal AI

- 著者: Jon E. Froehlich, Alexander J. Fiannaca, Nimer M Jaber, Victor Tsaran, and Shaun K. Kane.

- 発表会議: The 38th Annual ACM Symposium on User Interface Software and Technology (UIST ’25), September 28-October 01, 2025, Busan, Republic of Korea.

- DOI: https://doi.org/10.1145/3746059.3747756

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。