ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

科学技術の進歩を支える「学術論文」。その信頼性を担保してきたのが「査読(ピアレビュー)」という仕組みです。しかし、この伝統的なシステムが、今、限界に達していることをご存知でしょうか。

膨大な論文数、査読者の負担増、そして根深いバイアス。これらの問題は、科学の進歩そのものを遅らせる要因となっています。そんな中、解決策として大きな期待を寄せられているのが、大規模言語モデル(LLM)をはじめとするAI技術です。

本記事では、AIが学術査読の未来をどのように変えうるのか、その可能性とリスクについて、最新の研究論文をベースに深く、そしてロジカルに掘り下げていきます。

この記事は、きっとあなたの役に立ちます。

- AIの最新動向が、社会のどのような領域で活用され始めているか知りたい方

- 研究や論文執筆に携わっており、学術界の未来に関心がある方

- AIがもたらすメリットだけでなく、そのリスクや課題も正確に理解したい方

AIは単なる効率化ツールなのか、それとも知の門番そのものになり得るのか。本質を見極めていきましょう。

【本記事のベース論文】

タイトル: Al and the Future of Academic Peer Review

著者: Sebastian Porsdam Mann, et al.

雑誌名あるいは会議名: arXiv preprint server

出版年: 2025

目次

崩壊寸前?現代の学術査読が抱える深刻な課題

まず、現状の査読システムがどのような問題に直面しているのかを正確に理解する必要があります。理想とは裏腹に、その運営は多くの矛盾を抱えています。

終わらない「待ち時間」と経済的コスト

論文を投稿してから出版されるまで、平均して数ヶ月、時には1年以上かかることも珍しくありません。この出版遅延は、科学の進歩を阻害する大きな要因です。特に、キャリアの浅い若手研究者にとっては、業績評価に直結する死活問題となります。

さらに、査読はほとんどの場合、研究者による無償のボランティアで成り立っています。ある試算によれば、査読に費やされる研究者の時間を経済的価値に換算すると、世界全体で年間数千億円規模にものぼると言われています。この莫大なコストが、一部の良心的な研究者に不均衡にのしかかっているのが現実です。

質のばらつきと、見過ごされるエラー

複数の査読者によるチェック機能は、理論上は有効です。しかし、実際には査読者間での評価の一致率は驚くほど低く、「誰が査読者になるか」という偶然に結果が左右されかねない状況です。

さらに深刻なのは、エラー検出率の低さです。意図的に重大な誤りを仕込んだ論文を査読させる実験では、査読者が検出できたエラーは平均して全体のわずか4分の1程度だったという衝撃的な報告もあります。これは、現在のシステムが論文の質の管理の役割を十分に果たせていない可能性を示唆しています。

排除できない「バイアス」という名の歪み

査読プロセスには、様々なバイアスが潜んでいます。例えば、編集者が自分と同じ性別や、よく知るネットワーク内の研究者を査読者に選びがちな「ホモフィリー」が指摘されています。結果として、学術界における男女間の格差を助長する一因となっています。

また、著名な著者や有名大学に所属する研究者の論文が、無意識に高く評価される傾向もデータで示されています。言語的なバイアスも存在し、内容は同じでも、英語がネイティブでない研究者の論文は低い評価を受けがちです。これらのバイアスは、科学の公正性を根本から揺るがす問題です。

【ロジの視点】

現状の査読システムが抱える「遅延」「負担」「質のばらつき」「バイアス」という4つの課題は、互いに複雑に絡み合っています。査読者の負担が増えれば、一人ひとりの査読にかけられる時間は減り、質は低下します。その結果、エラーが見過ごされ、バイアスのかかった判断が下されやすくなる。この負のスパイラルこそが、現代の学術界が直面している構造的な問題の本質と言えるでしょう。AIの導入を議論する際には、この「人間によるシステムの限界」を客観的に認識することが不可欠です。

AIは「救世主」となりうるか?査読プロセスへの応用可能性

これらの根深い問題を解決する可能性を秘めているのが、LLMをはじめとするAI技術です。具体的にどのような貢献が期待できるのでしょうか。

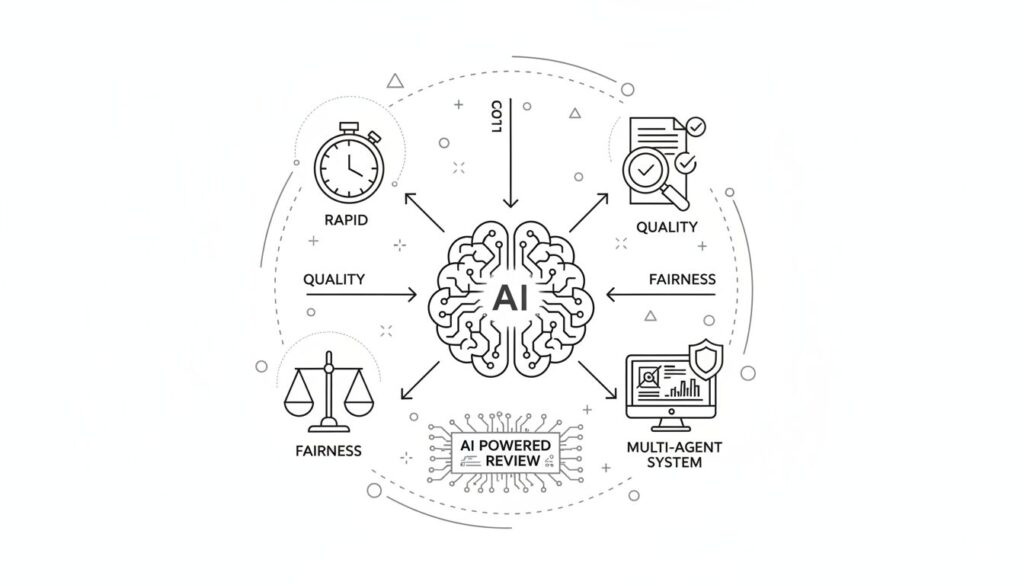

迅速化と効率化:時間という最大の敵に挑む

LLMは、論文の内容に合致する査読者を瞬時にリストアップしたり、査読レポートの草案を数分で作成したりできます。これにより、査読プロセス全体の大幅な時間短縮が期待されます。研究成果がより早く世に出ることで、科学全体の進歩が加速するでしょう。また、査読者の時間的負担を軽減することで、より多くの研究者が査読に参加しやすくなり、負担の偏りを是正する効果も考えられます。

品質と一貫性の向上:人間の目を超える検出力

近年の研究では、LLMによる査読の質は、人間によるものと同等か、場合によってはそれ以上である可能性が示唆され始めています。特に、複数のAIエージェントが異なる視点(例:手法の妥当性、論理構成、新規性など)から多角的に論文を評価する「マルチエージェント・システム」は、一貫性と網羅性の高いレビューを生成する上で非常に有望です。AIは統計的な誤りや引用文献の不整合といった、人間が見落としがちなエラーの検出にも長けています。

バイアスの軽減:より公正な評価を目指して

AIは、著者名や所属機関といった情報を完全に秘匿した上で、論文の内容だけを評価することが可能です。これにより、人間の査読者が無意識に抱いてしまう属人的なバイアスを排除できる可能性があります。もちろん、AIも学習データに含まれるバイアスを再生産するリスクはありますが、そのバイアスは人間と違って特定・計測しやすく、技術的に修正することが比較的容易であるという利点があります。

AI査読に潜むリスクと、それに対する反論

もちろん、AIの導入は良いことばかりではありません。専門家からは多くの懸念が表明されており、それらを無視することはできません。しかし、それらの懸念の多くは、技術的・制度的な対策によって乗り越えられる可能性があります。

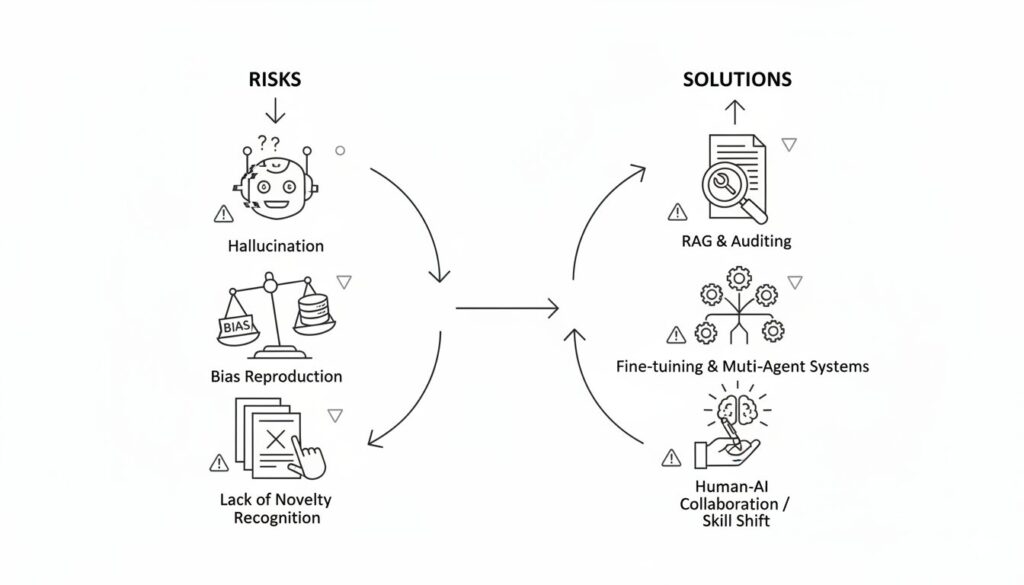

懸念1:ハルシネーション(もっともらしい嘘)とバイアスの再生産

【懸念】

LLMは、事実にない情報を生成する「ハルシネーション」を起こすことがあります。また、学習データに含まれる偏見を増幅させ、特定の研究アプローチやマイノリティグループの研究者を不当に低く評価する危険性も指摘されています。

【応答】

これらの問題は、AIを単体で(いわば”記憶”だけで)動作させた場合に起こりやすいものです。データベース検索や計算ツールと連携させる「Retrieval-Augmented Generation (RAG)」などの技術を用いることで、ハルシネーションは大幅に抑制できます。また、前述の通り、AIのバイアスは人間よりも監査・修正が容易です。重要なのは、理想化された人間と比較するのではなく、バイアスに満ちた現状の人間による査読システムと比較考量することです。

懸念2:新規性の認識と研究の均質化

【懸念】

過去のデータから学習するAIは、既存のパラダイムから大きく逸脱した、真に革新的な研究を正しく評価できないのではないか、という懸念があります。AIが「無難」な研究ばかりを評価すれば、科学全体の均質化が進み、イノベーションが阻害されるかもしれません。

【応答】

このリスクに対処するため、特定の学問分野や特定の評価基準に特化させた「ファインチューニング」が有効です。また、異なる分野の知識を学習したAIエージェントを組み合わせることで、一つの分野の常識に囚われた専門家が見逃すような、分野横断的な新規性を発見できる可能性すらあります。AIが出力する評価間の「意見の相違」を、むしろ革新的な研究のシグナルとして捉えるような設計も考えられます。

懸念3:人間の監視、過度な依存、そして専門スキルの低下

【懸念】

AIの評価を鵜呑みにする「自動化バイアス」に陥り、研究者が批判的な思考を放棄してしまう危険性があります。また、査読という行為を通じて若手研究者が得ていた、論文を批判的に読む訓練の機会が失われ、研究者コミュニティ全体の専門スキルが低下する(デスキリング)との指摘もあります。

【応答】

AIの導入は、人間の役割を不要にするのではなく、専門性のあり方を再定義するものと捉えるべきです。単純なチェック作業をAIに任せることで、人間はより高度な概念レベルの評価や、研究の独創性の吟味といった、本質的な部分に集中できるようになります。これは「スキルの低下」ではなく「スキルのシフト」です。重要なのは、AIを意思決定者としてではなく、あくまで人間の判断を補助する高度な支援ツールとして位置づけることです。

KEY SIGNAL:

AIは学術査読を「代替」するのではなく、人間の認知能力を「拡張」するツールである。その成否は技術そのものではなく、人間がAIをどのように設計し、運用するかにかかっている。

まとめ:AIと共存する、新しい研究評価のかたちへ

この記事のポイントをおさらいしましょう。

- 現代の学術査読は、「遅延」「負担」「質のばらつき」「バイアス」といった構造的な課題を抱え、限界に達している。

- AI(LLM)は、査読プロセスの迅速化、品質向上、バイアス軽減に貢献する大きな可能性を秘めている。

- ハルシネーションや新規性の認識といった懸念は存在するが、RAGやファインチューニング、マルチエージェントシステムといった技術的・制度的アプローチによってリスクを軽減できる。

- 最も重要なのは、AIを人間の代替ではなく、人間の判断を支援・拡張するためのツールとして賢く活用していく視点である。

AI査読の導入は、もはやSFの世界の話ではありません。それは、私たちが科学の信頼性と進歩を維持するために、真剣に検討すべき現実的な選択肢です。もちろん、その道筋は平坦ではなく、技術的な洗練と、透明性や説明責任を担保する慎重なガバナンス設計が不可欠です。

しかし、現状のシステムが抱える根深い問題を直視するならば、私たちは変化を恐れるべきではないでしょう。AIという強力なツールを賢く使いこなし、より公正で、より効率的で、より信頼性の高い知の生態系を築いていく。その挑戦は、すでに始まっています。

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。