ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

近年の大規模言語モデル(LLM)は、主要な性能評価ベンチマークで驚異的なスコアを記録し続けています。しかし、その数字はAIの真の「知性」を反映しているのでしょうか?専門家からは、既存ベンチマークの「飽和」と、訓練データに答えが含まれてしまう「データ汚染」により、AIの能力を正しく測れなくなる「評価の危機」が指摘されています。

この根源的な課題に対し、日本の北陸先端科学技術大学院大学(JAIST)の研究チームが、実にユニークな解決策を提示しました。それは、日本の子供たちに親しまれている「なぞなぞ」をAIの能力測定に用いるというものです。

本稿では、この画期的な研究論文「The Nazonazo Benchmark」を基に、なぜ「なぞなぞ」がAIの思考の深層を暴き出すのか、そして最新LLMが抱える決定的な弱点とは何かを、論文のデータに忠実に、ロジカルに解き明かしていきます。

この記事は、きっとあなたの役に立ちます。

- AIの能力評価の現状と課題を正確に理解したい方

- LLMの表面的な性能だけでなく、その思考プロセスに興味がある方

- 認知科学の観点からAIの「知性」の本質に迫りたい方

AIの「思考」の最前線へ、ご案内します。

【本記事のベース論文】

- タイトル: The Nazonazo Benchmark: A Cost-Effective and Extensible Test of Insight-Based Reasoning in LLMs

- 著者: Masaharu Mizumoto, et al.

- 所属: Japan Advanced Institute of Science and Technology (北陸先端科学技術大学院大学)

- 公開年: 2025年

なぜ「なぞなぞ」がAIの知性を測るのか?

「なぞなぞ」は単なる言葉遊びではありません。論文によれば、それは「ひらめき(Insight)」を必要とする、典型的な問題解決の縮図です。

思考の壁を壊す「表象の再構成」

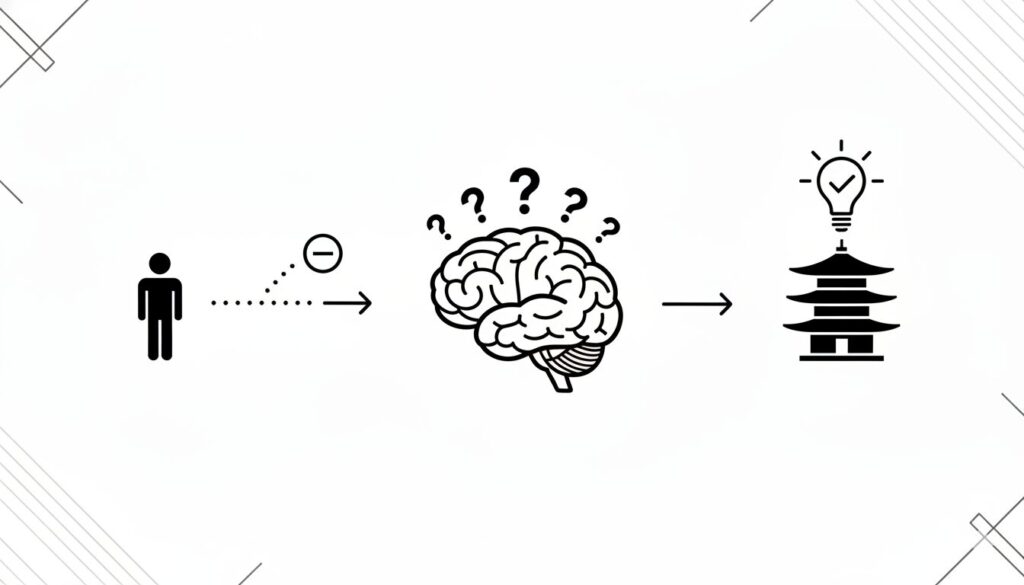

ひらめきが求められる問題では、私たちは無意識に作った思考の枠組みに行き詰まります(インパス状態)。この壁を乗り越える鍵が、認知科学で「表象の再構成(Representational Change)」と呼ばれるプロセスです。

論文で挙げられている例を見てみましょう。

問題: 「侍が人を斬って逃げた。どこへ隠れた?」

この問いに、侍の行動から答えを推測しようとしても行き詰まります。ここで必要なのは、「侍」という漢字を構成要素(チャンク)に分解し、「人(にんべん)」という制約を外して再構成するという思考の転換です。すると「侍」-「人」=「寺」という答えが「ひらめく」のです。

このプロセスは、知識の検索ではなく、思考の柔軟性を問うものであり、現在のLLMが最も苦手とする領域の一つです。

【ロジの視点】

この「表象の再構成」こそ、AIと人間の思考を分ける重要な境界線です。LLMは膨大な知識データベースから最適解を「検索」することに長けていますが、自ら設定した前提を疑い、思考の枠組み自体を「破壊」して新しい視点を得ることは、依然として大きな課題です。なぞなぞは、この根源的な能力の有無を鋭く問いただす、優れたリトマス試験紙なのです。

実験結果:最新LLM vs 人間

研究チームは、38の最先端LLMと126人の成人を対象に、最大201問のなぞなぞで比較実験を行いました。結果は、現在のAIの限界を明確に示しています。

GPT-5でさえ人間に及ばず

まず、人間の平均正答率が52.9%であったのに対し、論文で言及されているGPT-5でさえ、この人間の中央値に匹敵する性能を示せませんでした。他の多くのモデルに至っては、人間のスコアの半分にも満たないという惨敗でした。

興味深いのは、人間の成績が「0点」と「満点」にピークを持つ二峰性分布を示したことです。これは、なぞなぞには「ひらめける人」と「ひらめけない人」が明確に分かれる特性があることを示唆しており、まさに「ひらめき」の問題であることを裏付けています。

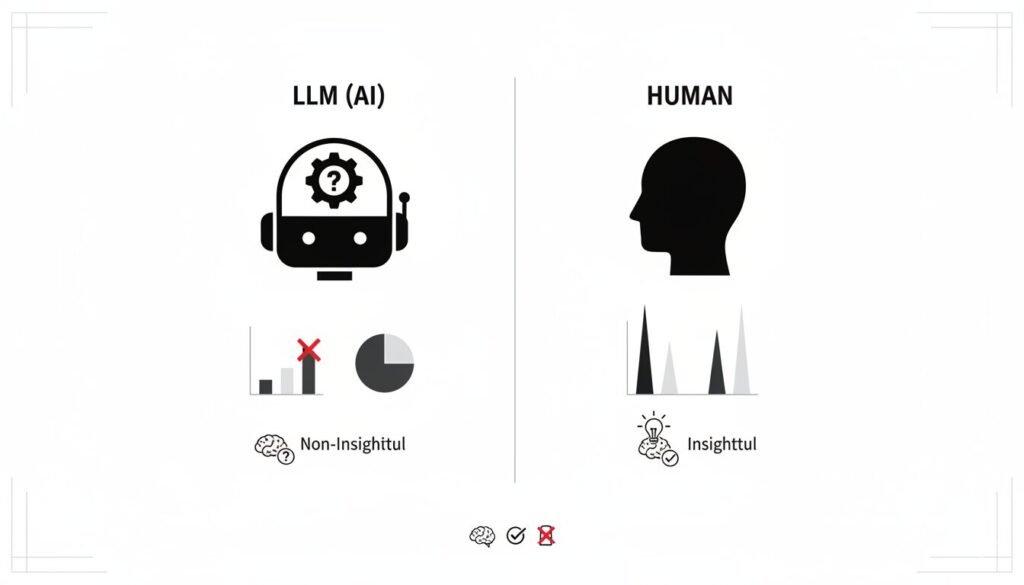

知性の鍵は「大きさ」より「思考の様式」

さらに、モデルの性能はパラメータサイズ(大きさ)とはほとんど相関がありませんでした。一方で、モデルをアーキテクチャによって「推論モデル」と「非推論モデル」に分けると、推論モデルが非推論モデルを統計的に有意に上回りました (Cohen’s d = 0.925)。これは、なぞなぞを解く能力が、単なる知識量ではなく、組み込まれた推論能力の質に依存することを示しています。

AIの思考ログが語る「決定的弱点」

本研究の白眉は、LLMが答えを導き出す過程を記録した「思考ログ」の詳細な分析にあります。そこから、AIの思考における決定的な弱点が浮かび上がりました。

正解に到達しても「確信」できないAI

最も衝撃的な発見は「検証の失敗(Verification Failure)」です。これは、思考の過程で一度は正しい答えを生成したにもかかわらず、それが正解であると認識できずに最終的に別の誤った答えを選んでしまう現象を指します。

例えば、あるモデルは「パーキング(駐車場)」と「キング(王様)」を結びつける正解のロジックに気づきながらも、「いや、これでは王様に繋がらない…」と自ら却下してしまいました。これは、正解を生成する能力はあっても、その正しさを確信する「正しさの感覚(Feeling of Rightness, FoR)」というメタ認知能力が欠如していることを示しています。

人間であれば「これだ!」と感じるひらめきの瞬間を、AIは素通りしてしまうのです。

KEY SIGNAL:

最先端LLMの思考における最大のボトルネックは、知識や計算能力の不足ではなく、生成した答えが本当に正しいかを判断し、確信をもって選択する「メタ認知制御」の弱さにある。この「検証の失敗」こそが、人間的なひらめきとAIの能力を隔てる深い溝である。

まとめ:次世代AIへの道筋

日本の「なぞなぞ」を用いたこのユニークな研究は、現在のAI評価の限界を明らかにし、LLMが抱える本質的な課題を浮き彫りにしました。

この記事のポイントをおさらいしましょう。

- 現在のAI評価は「評価の危機」にあり、知識量だけでなく「ひらめき」を測る新たな指標が求められている。

- 「なぞなぞ」は、思考の柔軟性を問う「表象の再構成」を必要とするため、AIのひらめき能力を測る理想的なツールである。

- 実験では、GPT-5を含む最先端LLMでさえ人間の平均正答率に及ばず、AIの性能はモデルサイズよりも推論の質に依存することが示された。

- 思考ログ分析により、AIは正解を一度は生成しても確信できずに見捨てる「検証の失敗」が頻発することが判明。これはメタ認知能力の欠如が原因である。

この研究が示すのは、AI開発の未来は、単にモデルを大きくし、より多くのデータを学習させる方向だけにはない、ということです。自らの思考を客観視し、その正しさを判断するメタ認知能力をいかにしてAIに実装するか。それこそが、真に人間のような知性を創造するための、次なる挑戦となるでしょう。

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。