ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

長年、AI開発の主役はクラウドでした。しかし、多くの開発者が直面するデータプライバシー、コスト、常時接続への依存といった根源的な課題が、今「ローカルAI」への地殻変動を引き起こしています。

この新しい潮流の中、Microsoftが投入した「Foundry Local」と「AI Toolkit」は単なる新製品ではありません。これらは、AIを完全に手元のPC内で完結させることで、開発の未来そのものを再定義する、極めて戦略的な一手と言えるでしょう。https://atmarkit.itmedia.co.jp/ait/articles/2509/25/news039.html

この記事は、きっとあなたの役に立ちます。

- AIの導入を検討しているが、セキュリティやプライバシーに懸念を持つ開発者の方

- AIアシスタントの月額コストを、本質的な課題だと感じているエンジニアの方

- クラウドAIだけでなく、最新のローカルAIの動向を正確に把握したい技術リーダーの方

本記事では、この動きが持つ4つの本質を解き明かし、なぜこれが全ての開発者にとって無視できない変化なのかを論理的に解説します。

目次

これは単なるトレンドではない。AIの「再分散化」を巡る戦略的攻防だ

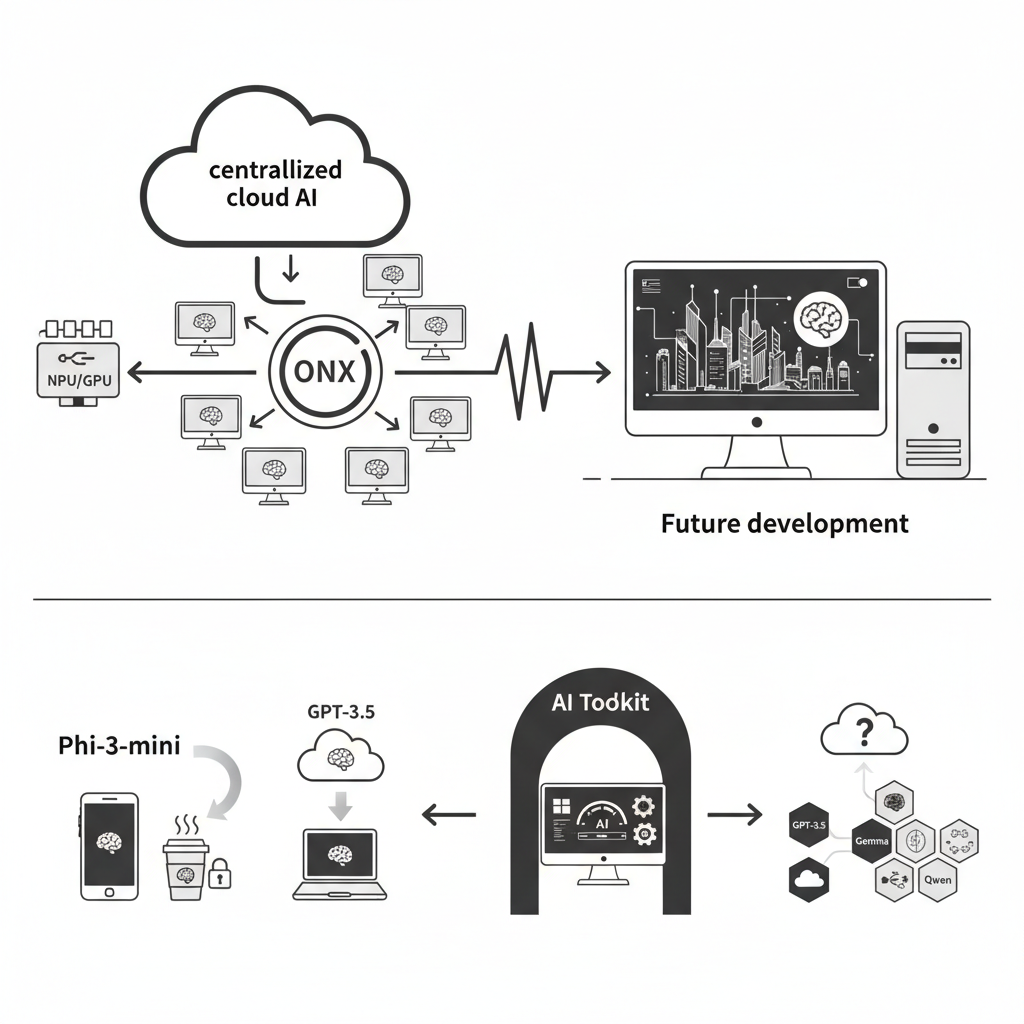

ローカルAIへのシフトは、単なる技術トレンドではなく、AIの主導権を巡る大きな構造変化の始まりです。それは、これまで一部の大手クラウドプロバイダーに集中していたAIの力を、開発者個人の手元へと取り戻す「再分散化」の動きに他なりません。

この動きの背景には、従来のクラウドAIが抱える3つの根本的な課題があります。

- プライバシーとセキュリティの懸念: クラウドAIの利用は、機密情報や開発中のソースコードを外部サーバーに送信することを意味します。特に高度な機密性が求められるプロジェクトでは、このリスクがAI導入の大きな障壁となっていました。

- 無視できない利用コスト: 高性能なAIモデルの維持には莫大なサーバーコストがかかり、それが毎月の利用料金に反映されます。個人にとっても企業にとっても、このコストは決して無視できません。

- インターネット接続への依存: クラウドAIは、オフライン環境では利用できません。移動中やセキュリティで隔離された環境では、その恩恵を受けられないという制約がありました。

Microsoftの「Foundry Local」への参入は、この「再分散化」という巨大なうねりを、自社のAzureとWindowsエコシステムの新たな柱へと転換するための戦略的な一手です。彼らは、ローカルAIという流れが自社の影響外で進化するのを座して待つのではなく、WindowsとVS CodeをローカルAI開発のデファクトスタンダードなプラットフォームとして位置づけることで、この波を自らのエコシステムを強化する絶好の機会へと変えようとしているのです。

利便性より性能:「ONNX」が明かすMicrosoftの真の狙い

Foundry Localは、Ollamaのように様々なモデル形式をそのまま扱える手軽さ(プラグアンドプレイ)とは一線を画し、モデルを「ONNX」形式へ事前にコンパイルすることを必須としています。

これは単なる技術的な選択ではなく、戦略的なトレードオフです。この一手間を要求する代わりに、NPUやGPUといった最新のWindowsハードウェアの性能を最大限に引き出し、クラス最高のパフォーマンスを実現するというMicrosoftの強い意志が表れています。

【ロジの視点】

Ollamaのような手軽さも魅力的ですが、Microsoftが「ONNX」という一手間を要求する背景には、将来の「AI PC」時代を見据えた、ハードウェアレベルでの性能最適化という明確な意図が読み取れます。これは、単なるツール提供ではなく、エコシステム全体を支配しようとする彼らの野心的な戦略の表れです。

この選択は、Microsoftが将来の「AI PC」時代を完全に見据えていることの証左です。彼らは単なるAIの実行環境(ランタイム)を提供するのではなく、ハードウェア(NPU)からOS(Windows)、開発環境(VS Code)に至るまで、垂直統合された高性能なスタックの支配を狙っているのです。

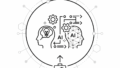

競合さえも飲み込む「AI Toolkit」の巧みなゲートウェイ戦略

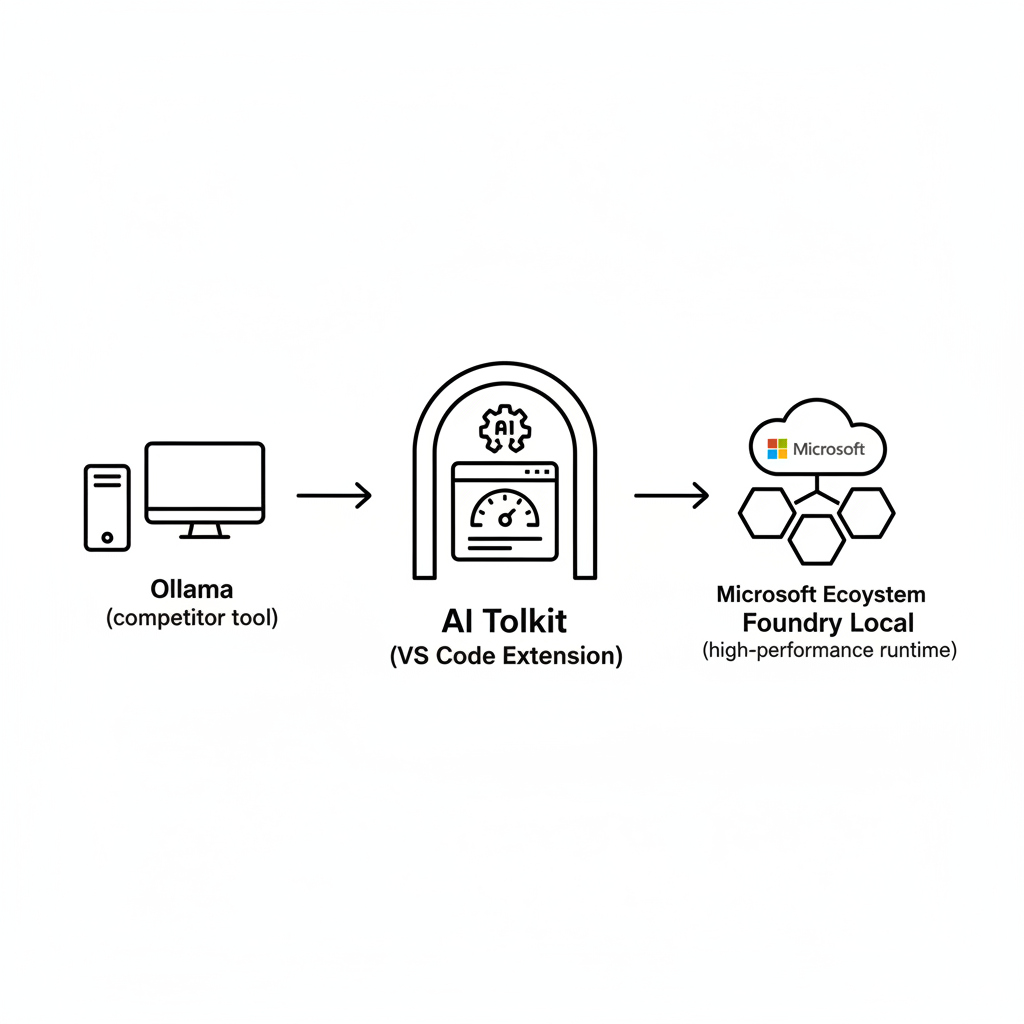

VS Codeの拡張機能である「AI Toolkit」の最も驚くべき点は、Microsoft製品だけでなく、Ollamaのような競合するローカルAIツールも公式にサポートしていることです。

これは、Microsoftの巧みな「ゲートウェイ戦略」に他なりません。

まず、AI Toolkitを全てのAI開発者にとって不可欠な「メタプラットフォーム」として普及させます。一度開発者がその便利で中立的なエコシステムに入ってしまえば、Microsoft独自の高性能ランタイムであるFoundry Localを試すための心理的な障壁は劇的に下がります。

これは、かつてVS Codeでオープンソース開発者を、あるいはTypeScriptでJavaScriptコミュニティを惹きつけたのと同じ戦略の再来です。まず価値あるツールを提供して開発者のワークフローの中心となり、そこから自社サービスへの移行を促すという、Microsoftの得意とする手法なのです。

「ミニ」が巨大モデルを凌駕する:Phi-3が拓くオンデバイスAIの現実

ローカルAIが現実的な選択肢となった最大の要因は、小型でありながら驚異的に高性能なSLM(小規模言語モデル)の台頭です。

その象徴が、Microsoftの「Phi-3-mini」モデルです。わずか38億パラメータというサイズでありながら、はるかに巨大なGPT-3.5に匹敵する性能を持ち、iPhoneのようなデバイス上でも実行可能であるという事実は衝撃的です。

Phi-3-miniの登場は、これまでハイエンドなクラウドサーバーでしか不可能だったタスクが、オフラインのラップトップやスマートフォンで実行可能になる時代の到来を告げています。これにより、AIアプリケーションの「常時接続」という前提が根本から覆されるのです。

KEY SIGNAL:

これからの開発の未来は、クラウドの圧倒的なパワーと、ローカルの持つ即時性・プライバシー・コスト効率を融合させた「ハイブリッドアプローチ」が標準となります。

さらに、AI Toolkitを使えば、Phi-3だけでなく、Googleの「Gemma」や多言語に強い「Qwen」など、プロジェクトの目的に応じて様々なオープンソースモデルを自由に選択し、切り替えることも可能です。

まとめ:あなたのPCを、次世代のAI開発拠点に

Microsoftの一連の動きは、ローカルAIが実験的な段階を終え、本格的な主流になったことを示す象B徴的な出来事です。

この記事のポイントをおさらいしましょう。

- ローカルAIへのシフトは、クラウド集中からの「再分散化」という大きな構造変化です。

- Microsoftは「ONNX」形式を採用し、ハードウェア性能を最大限に引き出す垂直統合戦略を狙っています。

- 「AI Toolkit」は競合ツールもサポートし、開発者の入口となり自社エコシステムへ誘導するゲートウェイ戦略です。

- Phi-3のような高性能SLMの登場により、オフライン環境での高度なAI利用が現実のものとなりました。

AIが瞬時に応答し、プライベートで、常に手元のデバイスで利用可能になったとき、あなたは一体どんな新しいアプリケーションを創造しますか? 未来の開発体験は、もう始まっています。

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。