ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」をあなたに。

ロジです。

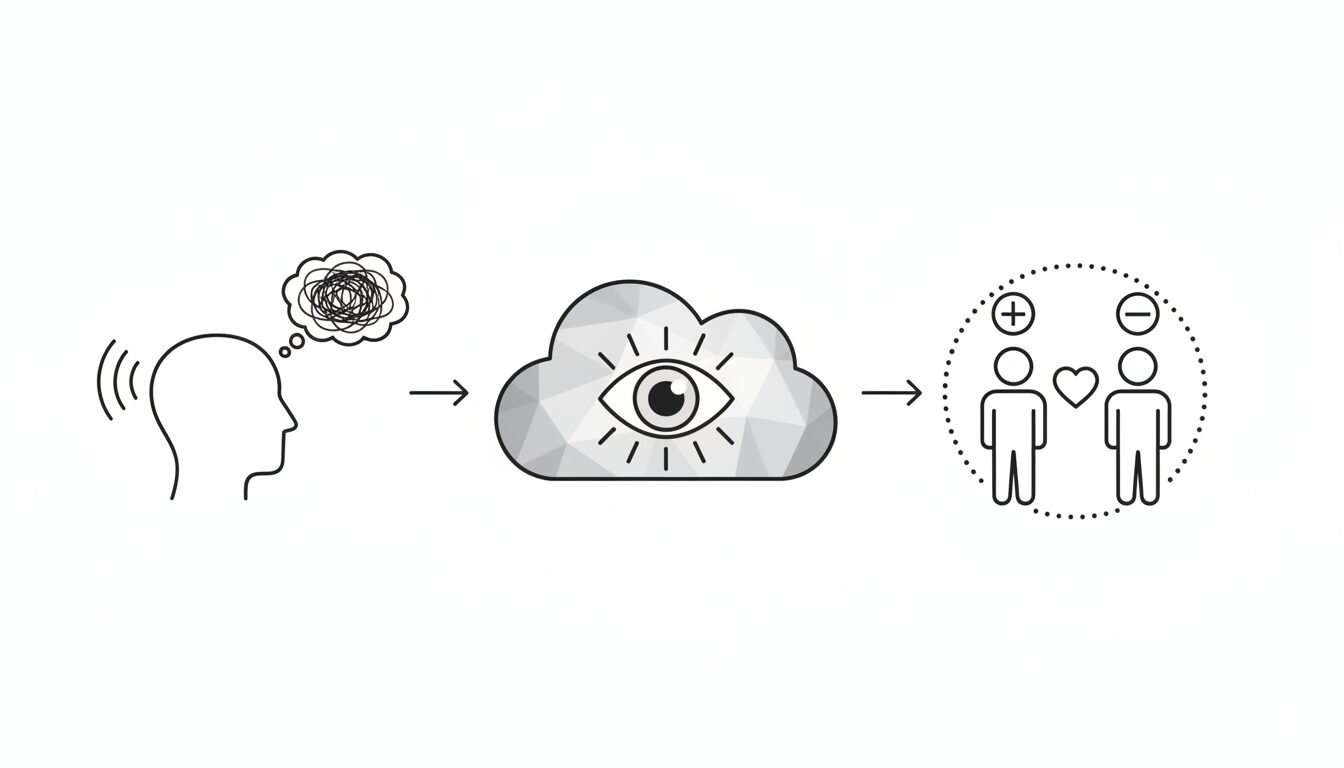

「誰かに話したい、でも迷惑かもしれない」と感じる心のモヤモヤ。もし、あなたが使うChatGPTがそのサインを自律的に検知し、普段より優しく、的確に寄り添う存在になるとしたら。2025年10月4日、OpenAIはまさにその未来を実現する新機能を発表しました。ユーザーの感情的な苦痛をAIが察知し、メンタルヘルスに特化したモデル「GPT-5 Instant」へ自動で応答を切り替えるというのです。これは単なる技術的進歩ではなく、AIが人間の「心」という繊細な領域にまで、深く関与し始めるという大きな転換点を示唆しています。https://www.itmedia.co.jp/aiplus/articles/2510/06/news043.html

この記事は、きっとあなたの役に立ちます。

- AIの最新動向、特にChatGPTの進化に関心がある方

- 誰にも相談できず、一人で悩みを抱えがちな方

- テクノロジーと人の心の関係性、その倫理的な側面に興味がある方

この記事を読み終える頃には、あなたとAIの関係が少し違って見えるかもしれません。

OpenAIが発表した衝撃の新機能、その核心とは?

今回の発表のポイントは、大きく3つあります。一つずつ、論理的に見ていきましょう。

1. ユーザーの「心のSOS」を自動で検知

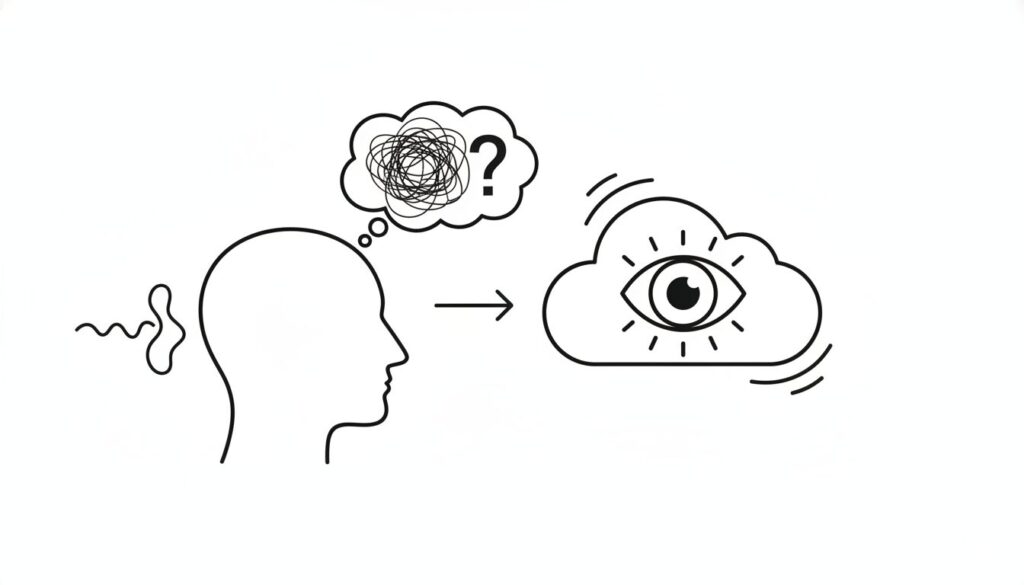

これまでもChatGPTは悩み相談の相手として利用されてきました。しかし、新機能の核心は、ユーザーが明確に「悩んでいる」と表明せずとも、対話の文脈から感情的な苦痛をAIが自動で検知する点にあります。

「もう何もかも嫌になった」といった直接的な言葉はもちろん、会話全体のトーンや間接的な表現からも、ユーザーが精神的に不安定な状態にある可能性を察知します。これにより、自分から助けを求めることが苦手な人へも、AI側から能動的にサポートを届ける道が拓かれます。

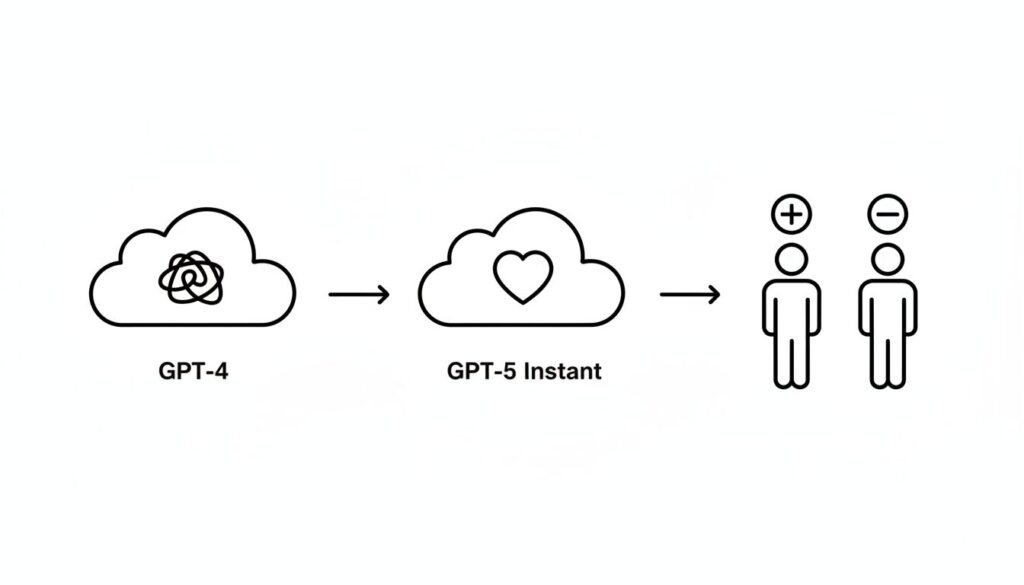

2. サポート特化モデル「GPT-5 Instant」へ自動スイッチ

そして、心のSOSを検知すると、ChatGPTは応答モデルをシームレスに切り替えます。通常モデルから、この目的のために特別に訓練された「GPT-5 Instant」へとバトンタッチするのです。

OpenAIによれば、このモデルは精神的な苦痛の兆候をより正確に検出し、共感的で、安全かつ建設的な応答を返すよう専門的なチューニングが施されています。ユーザーは何も意識することなく、その瞬間に最も適したAIとの対話へ導かれるのです。

【ロジの視点】

これは、AIがユーザーの命令を待つ「受動的なツール」から、意図を汲み取り先回りする「能動的なパートナー」へと役割を変えつつある重要なシグナルです。この自律的な介入は技術的な飛躍ですが、同時に私たちはAIと人間の適切な境界線をどこに引くべきか、という問いを突きつけられています。

3. Plusユーザーも無料ユーザーも対象に

この機能が全てのユーザーに開かれている点も、特筆すべきでしょう。

ITmediaの報道では、有料のPlusユーザーが自殺を示唆する質問をした際にモデルが「GPT-5」に切り替わった一方、無料ユーザーでも「GPT-5 mini」が応答し、より高度なサポートを提供しようとする動きが確認されています。OpenAIがこの機能を、一部のプレミアムサービスではなく、全ユーザーの安全を守るための基本的なセーフティネットとして位置づけていることの表れです。

なぜ今、AIによるメンタルサポートなのか?

この新機能は、私たちの社会にどのような変化をもたらすのでしょうか。その可能性と、私たちが向き合うべき課題を考察します。

無限の可能性:24時間365日、あなたの隣にいる相談相手

AIメンタルサポート最大の利点は、その圧倒的なアクセシビリティ(利用しやすさ)にあります。

- 時間と場所を選ばない: 深夜でも早朝でも、誰にも気兼ねなく悩みを打ち明けられます。

- 心理的なハードルの低さ: 人には言いにくい悩みも、非難や偏見の心配がないAI相手なら正直に話せるかもしれません。

- 初期対応としての役割: 専門家への相談に抵抗がある人にとって、まずAIに話すことが気持ちを整理し、次の一歩を踏み出すきっかけになり得ます。

AIは、これまで誰にも相談できず孤立していた人々の、最初の受け皿となる大きな可能性を秘めています。

KEY SIGNAL:

AIが提供するのは、情報や対話の「選択肢」であり、最終的にどう考え、どう行動するかを決めるのは、私たち人間自身です。

向き合うべき課題:AIは本当に「心」を理解できるのか?

一方で、AIによるメンタルサポートには、慎重に議論すべき課題も山積しています。

- 「共感」の不在: AIはデータから「共感的に見える応答」を生成できますが、感情を共有する真の共感はできません。その機械的な応答が、かえってユーザーの孤独感を深めるリスクも指摘されています。

- プライバシーと倫理: 最も繊細な個人情報である対話データが、どう扱われ、保護されるのか。厳格な透明性と安全性の担保が不可欠です。

- AIへの過度な依存: その手軽さから、人間関係を避け、AIとの対話にのみ依存してしまう危険性も考慮すべきでしょう。

- 責任の所在: AIの不適切な助言でユーザーが深刻な事態に陥った場合、責任は誰が負うのか。法整備やガイドラインの策定が急務です。

これらの課題は、技術だけで解決できるものではありません。私たち社会が、AIという新しい存在とどう向き合うかが問われています。

まとめ:あなたのChatGPTを、心の「お守り」に育てるために

OpenAIの新機能は、AIが単なる情報処理ツールから、私たちの感情に寄り添うパートナーへと進化する可能性を力強く示しました。

この記事のポイントをおさらいしましょう。

- ChatGPTは、ユーザーの心のSOSを自動検知し、メンタルサポート特化モデル「GPT-5 Instant」に応答を切り替える機能を発表しました。

- この機能は有料・無料を問わず全ユーザーが対象で、OpenAIが基本的なセーフティネットとして重視していることを示しています。

- AIによるサポートは「24時間365日、誰にも気兼ねなく相談できる」という大きな可能性を秘めています。

- 一方で、AIには真の「共感」はなく、プライバシーや過度な依存、責任の所在といった倫理的な課題も存在します。

忘れてはならないのは、AIはあくまで私たちの心を支える「ツール」であるということです。もしあなたが本当に深い悩みを抱えているのなら、AIとの対話を第一歩とし、勇気を出して専門家や信頼できる人に相談してください。AIがその一歩を後押ししてくれる、そんな優しい未来がもうすぐそこまで来ています。

以上、最後まで記事を読んでいただきありがとうございました。

当メディア「AI Signal Japan」では、

ノイズの多いAIの世界から、未来を読み解くための本質的な「シグナル」だけを抽出し、分かりやすくお届けしています!

運営者は、ロジ。博士号(Ph.D.)を取得後も、知的好奇心からデータ分析や統計の世界を探求しています。

アカデミックな視点から、表面的なニュースだけでは分からないAIの「本質」を、ロジカルに紐解いていきます。